Информация и информационные процессы

Информация и информационные процессы. Кодирование информации.

Штана Альберт Игоревич

Теория

Информация — это сведения об окружающем мире, которые снижают уровень неопределённости знаний о нём.

Виды информации

- По способу восприятия: Визуальная, Аудиальная, Вкусовая, Обонятельная, Тактильная, Вестибулярная, Мышечная(благодаря мышечной информации у человека развивается способность печатать на клавиатуре в слепую).

- По назначению: Массовая, Специальная, Секретная, Личная.

- По форме представления: Текстовая, Числовая, Звуковая, Графическая, Видеоинформация.

- По истинности: Истинная, Ложная.

p.s. Здоровый человек получает с помощью органов зрения (визуально) около 80-90% информации, с использованием органов слуха (аудиально) - порядка 8-15%, благодаря остальным органам чувств (обонянию, вкусу, осязанию) - только 1-5%. При утрате одного из информационных каналов (зрения, слуха, вкуса, обоняния или осязания) усиливается информационная роль оставшихся.

Свойства информации

Объективность. Актуальность. Полнота. Достоверность. Полезность. Понятность. Дискретность.

- Объективная информация — это информация независящая от чьего-либо мнения, суждения.

- Актуальная информация — это информация важная и существенная для настоящего времени.

- Полная информация — это информация достаточная для понимания ситуации и принятия решения.

- Достоверная информация — это информация отражающая истинное положение дел.

- Полезная информация — это информация, которая оценивается по тем задачам, которые можно решить с её помощью.

- Понятная информация — это информация выраженная на языке, доступном для получателя.

- Дискретная информация — это информация, которая может быть разделена на элементарные фрагменты или части с последовательными и точными значениями некоторой величины.

Единицы измерения количества информации

Термин количество информации используют в устройствах цифровой обработки и передачи информации, например в цифровой вычислительной технике(компьютерах), для записи объёма запоминающих устройств, количества памяти, используемого программой. Бит (англ. binary digit) bit — это наименьшая единица измерения информации("двоичная единица информации") и количество информации, необходимое для однозначного определения одного из двух равновероятностных событий. Например, один бит информации получает человек при ответе на вопрос да или нет. Байт - последовательность из 8 двоичных разрядов битов(наиболее популярная единица измерения информации).

Степени числа 2

| 1 | 2 | 4 | 8 | 16 | 32 | 64 | 128 | 256 | 512 | 1024 | 2048 |

Производные единицы измерения количества информации

Бит бит (0 или 1)

Килобит Кбит 2^10 бит = 1024 бит p.s. не путать со скоростью передачи информации - 1 Кбит/с = 1000 бит/с

Мегабит Мбит 2^20 бит = 1024 Кбит

Гигабит Гбит 2^30 бит = 1024 Мбит

Терабит Тбит 2^40 бит = 1024 Гбит

Петабит Пбит 2^50 бит = 1024 Тбит

Байт байт 8 бит

Килобайт Кбайт 2^10 байт = 1024 байт

Мегабайт Мбайт 2^20 байт = 1024 Кбайт

Гигабайт Гбайт 2^30 байт = 1024 Мбайт

Терабайт Тбайт 2^40 байт = 1024 Гбайт

Петабайт Пбайт 2^50 байт = 1024 Тбайт

Формула для измерения объёма информации

Примеры задач по теме измерение количества информации:

📍Выполните перевод:

а) в биты: 6 Кбайт;

б) в байты: 1 Мбайт;

в) в Килобайты: 4096 бит.

Решение:

а) В биты: 6 Кбайт = 6 * 8 Кбит = 48 Кбит. 48 Кбит = 48 * 1024 = 49152 бит. Ответ: 49152 бит.

б) В байты: 1 Мбайт = 1024 Кбайт = 1024 * 1024 байт = 1 048 576 байт. Ответ: 1 048 576 байт.

в) В Килобайты: 4096 бит = 4096 / 1024 = 4 Кбит = 4 / 8 = 0.5 Кбайт. Ответ: 0.5 Кбайт.

📍Статья, набранная на компьютере, содержит 32 страницы, на каждой странице 40 строк, в каждой строке 48 символов. Определите размер статьи в кодировке КОИ-8, в которой каждый символ кодируется 8 битами.

Решение:

Необходимо найти количество символов в статье: 32 (страницы) * 40 (строк) * 48 (символы) = 32 * (5 * 8) * (3 * 16) = 2^5 * 5 * 2^3 * 3 * 2^4 = 15 * 2^12.

Один символ кодируется одним байтом, 2^10 байт составляют 1 Кбайт, поэтому информационный объём статьи составляет: 15 * 2^12 байт = 15 * 2^2 * 2^10 байт = 15 * 2^2 Кбайт = 60 Кбайт.

Ответ: 60 Кбайт.

📍В одной из кодировок Unicode каждый символ кодируется 16 битами. Коля написал текст (в нём нет лишних пробелов, символы переноса слов не учитываются): "Москва, Санкт-Петербург, Новосибирск, Екатеринбург, Пенза, Казань, Челябинск, Омск, Самара, Ростов-на-Дону, Уфа, Красноярск, Воронеж, Пермь, Волгоград, Ульяновск, Барнаул, Иркутск, Липецк, Ярославль, Владивосток - города России". Ученик вычеркнул из списка название одного города. Заодно он вычеркнул ставшие лишними запятые и пробелы - два пробела не должны идти подряд. При этом размер нового предложения в данной кодировке оказался на 14 байт меньше, чем размер исходного предложения. Среди городов, имеющих одинаковое количество букв, Коля вычёркивает первый по порядку. Напишите в ответе вычеркнутое название города.

Решение:

Один символ кодируется 16 битами. Если перевести их в байты, то получится 2 байта. Следовательно, из текста удалили 7(14 байт / 2 байта) символов. Заметим, что лишние запятая и пробел занимают 2 + 2 = 4 байта. Значит, название города, которое удалили из списка, должно состоять из 5 букв ((14байт - 4 байт) / 2 байт). Первое название города, которое состоит из 5 букв это Пенза, значит Коля вычеркнул слово Пенза, (удалил вместе с запятой и пробелом).

Ответ: Пенза.

Виды информационных процессов

Информационный процесс представляет собой всё что происходит с информацией. Выделяют три вида информационных процессов: передача, хранение и обработка информации. Они являются базовыми, а их выполнение порождает другие информационные процессы. Передача — перемещение информации от источника к приёмнику по каналу передачи. Информация передаётся в форме сигналов(текстовых, световых, звуковых, ультразвуковых, электрических, графических и др.). Каналом связи может быть воздух(сигнальный огонь на маяке), электрические и оптоволоконные кабели(для передачи любого вида современной информации), отдельные люди(новости, идеи), нервные клетки человека(импульсы) и т.д. Хранение — информационный процесс обеспечения сохранности информации в памяти людей или же на каких-либо внешних носителях. На протяжении многих столетий основным носителем информации была бумага. В настоящее время также распространены электронные носители информации: облачные сервисы(удалённые сервера), внешние носители(диски, флеш-память) и пр. Обработка информации — вся совокупность операций (сбор, защита, преобразование, в том числе кодирование и декодирование, считывание, уничтожение), осуществляемых при помощи человека, технических и программных средств, включая обмен по каналам передачи данных. В результате обработки информации можно получить новые знания из имеющихся. Некоторые операции обработки информации: Сбор информации предполагает поиск и отбор необходимых данных из различных источников: работу с литературой, справочниками, проведение экспериментов, наблюдений, опросов, поиск в Интернете и т.д. Например, чтобы написать реферат, необходимо найти информацию по данной теме. Для сбора информации используют различные измерительные устройства. Например: для определения температуры воздуха на улице необходим термометр. Защита информации — создание условий, при которых не допускается случайной потери, изменения, повреждения данных или несанкционированного доступа к ним. Способы защиты: создание резервных копий, хранение на защищённом носителе, предоставление прав доступа узкому кручу пользователей, шифрование и др. Кодирование информации — это преобразование информации в символьную форму, удобную для хранения, передачи, обработки. Кодирование используется в технических средствах роботы с информацией (телеграф, компьютеры). Декодирование — процесс восстановления изначальной формы представления информации, т.е. процесс, обратный кодированию, при котором закодированное сообщение переводится на язык, понятный получателю.

📍Какие информационные процессы можно назвать из приведённого текста? "Школьник получил информацию в виде условия задачи, подумал, решил её в соответствии с определёнными правилами(например, правилами решения математических задач) и получил искомый результат".

Решение:

Школьник получил информацию - сбор и передача информации. Школьник решил задачу — обработка информации.Ответ: сбор, передача и обработка.

Кодирование и декодирование информации

В процессах передачи, хранения и обработки информации происходит её кодирование. Информационным кодом (кодовым словом или просто кодом) называется символьная последовательность, которая несёт в себе конкретную информацию. Каждый код имеет определённую длину, т.е. состоит из конечного числа символов, это количество называется длиной кода. Например, последовательность цифр в номере телефона, букв в текстовом сообщении является информационным кодом.

Виды кодирования: Равномерное кодирование — вид кодирования, при котором все символы какого-либо алфавита кодируются кодами одинаковой длины. Чтобы понять, какая длина кода будет у одного символа при равномерном кодировании, понадобится формула Хартли, позволяющая определить количество информации. Формула Хартли: N = 2^i, где N - количество равновероятностных событий, i - количество информации, которую мы получим при наступлении одного из событий. Эту закономерность Ральф Хартли обнаружил в 1928 году. Из данной формулы можно вывести i: i = log2N. Для определения количества информации при возникновении случайных событий(события не равновероятны) используя другая формула - формула Клода Шеннона. Мощность алфавита - количество символов/знаков, из которых состоит рассматриваемый алфавит.

📍Чтобы провести кодирование русскоязычного сообщения, нужно воспользоваться равномерным кодом. В первую очередь необходимо вспомнить количество букв в русском алфавите - 33. Затем следует воспользоваться формулой Хартли, чтобы определить количество бит, необходимых для кодирования одного символа(при условии что появление каждого из символов в сообщении - имеет одинаковую вероятность).

Решение:

Посчитаем, сколько требуется бит информации для кодирования одного символа из русского алфавита: 2^i = 33. Поскольку i - минимальное натуральное число, то i = 6. Можно сделать вывод, что для кодирования сообщения нам требуется равномерный код длинной 6 бит.Ответ: 6 бит.

Неравномерное кодирование

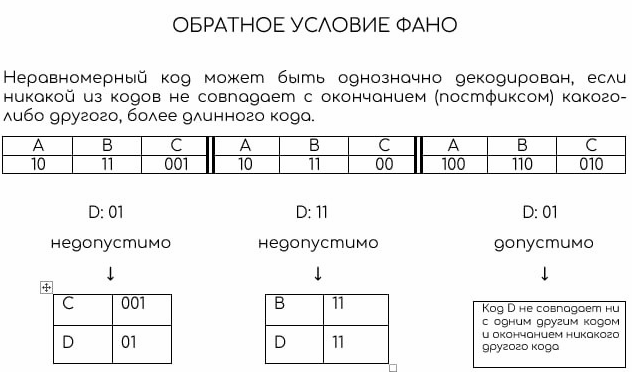

Неравномерное кодирование — вид кодирования, при котором все элементы какого-либо множества кодируются кодами различной длины. Общий принцип неравномерного кодирования заключается в том, чтобы кодировать наиболее часто используемые элементы как можно меньшим количеством бит, поскольку ими приходится оперировать очень часто. Главное при таком кодировании - обеспечить возможность однозначного декодирования записанной с помощью этих кодов строки (поочерёдного, слева направо, выделения и распознавания из сплошной последовательности нулей и единиц кодов отдельных букв). Для этого коды символам необходимо назначать в соответствии с условиями Фано, лежащими в основе теории кодирования. Сформулировать прямое условие Фано можно так: "Ни одно кодовое слово не может выступать в качестве начала любого другого кодового слова". С математической точки зрения условие звучит так: "Если код содержит слово А, то для любой непустой строки В слова АВ не существует в коде". Существует также обратное условие Фано, которое гласит: "Ни одно кодовое слово не может выступать в качестве окончания любого другого кодового слова". С математической точки зрения обратное условие можно сформулировать так: "Если код содержит слово B, то для любой непустой строки C слова СВ не существует в коде".

Декодирование может быть однозначным и многозначным. Если при расшифровке возможно получить несколько различных вариантов исходного сообщения, то такое декодирование неоднозначно. При расшифровке с единственным возможным результатом сообщения имеет место однозначное декодирование. Для однозначности декодирование последовательности кодов достаточно выполнения хотя бы одного из двух условий Фано: ❕при выполнении прямого условия Фано последовательность кодов однозначно декодируется с начала; ❕при выполнении обратного условия Фано последовательность кодов однозначно декодируется с конца. Выбрать, какое из двух правил Фано используется при решении конкретной задачи, можно, проанализировав коды в условии задачи (без учёта кода, проверяемого в вариантах ответа): если для исходных кодов выполняется прямое правило Фано, то его и нужно использовать при решении, и наоборот. Необходимо помнить, что правила Фано - это достаточное, но не необходимое условие однозначного декодирования: если не выполняется ни прямое, ни обратное правило Фано, конкретная двоичная последовательность может оказаться такой, что она декодируется однозначно(т.к. остальные возможные варианты до конца декодирования довести не удаётся). В подобном случае необходимо пытаться строить дерево декодирования в обоих направлениях.

📍По каналу связи передаются сообщения, содержащие только семь букв: А, Б, И, К, Л, О, С. Для передачи используется двоичный код, удовлетворяющий условию Фано. Кодовые слова для некоторых букв известны: А - 001, И - 01, С - 10. Какое наименьшее количество двоичных знаков потребуется для кодирования слова КОЛОС?

Решение:

Нужно закодировать три буквы: К, О, Л. Буква О встречается в слове 2 раза, поэтому её закодируем минимальным количеством знаков, например О - 000. К и Л не могут начинаться с 000, 10, 01, 001 по условию Фано, поэтому они кодируются как 110 и 111. Можно рассмотреть вариант, где О - 11, тогда К и Л не могут начинаться с 11, 001, 10, 01. В таком случае это будет вариант 0001 и 00001. Посчитаем количество битов, необходимое для кодирования слова КОЛОС в каждом случае. 1) К - 110, О - 000, Л - 111, О - 000, С - 10 = 14 битов. 2) К - 0001, О - 11, Л - 00001, О - 11, С - 10 = 15 битов. Выбираем в ответ наименьшее - 14 битов. Ответ: 14. (p.s. Иногда процесс декодирования проще начинать с конца зашифрованного сообщения).

📍Закодируем неравномерным кодом часть товаров, находящихся на товарном складе. Предположим, что на складе размещается около 3000 различных товаров, но наиболее потребляемыми являются хлеб, соль, молоко и сахар.

Решение:

Данные четыре товара покупают огромными партиями, и очень утомительно вести записи в базе данных, постоянно внося названия этих продуктов. Можно применить следующее кодирование: Хлеб - 00, Соль - 01, Молоко - 10, Сахар - 11. Итого нам потребовалось 2 бита информации. Далее уже закодируем любые другие оставшиеся на складе товары, например: Мука - 001, Перец - 010. Значит, мы выделили на кодирование товаров уже 3 бита информации. Необходимо понять общий принцип - чем менее популярен товар, тем большим количеством бит он должен быть кодирован.

Далее запишем практические задания...

Процесс передачи информации

Источник и приёмник

Передача информации — один из самых важных информационных процессов в современном мире. Без него невозможно создание общемирового информационного пространства, быстрое развитие науки и общение в социальных сетях. Клод Шеннон, создатель теории информации и основоположник цифровой связи, разработал общую схему передачи информации. Процесс передачи информации/сообщения/сигнала идёт от источника, далее сигнал кодируется и по каналу связи передаётся (иногда с шумом и помехами). Перед тем как попасть к приёмнику, сообщение декодируется. Участники процесса передачи информации:

- источник - тот, кто отправляет информацию;

- приёмник - тот, кто принимает информацию, причём их может быть несколько;

- канал связи - то, по чему передаётся информация.

Процесс передачи информации: источник → кодирование → канал(на него воздействуют: шум/помехи и защита от шума/помех) → декодирование → приёмник.

Аналоговое и дискретное представление информации

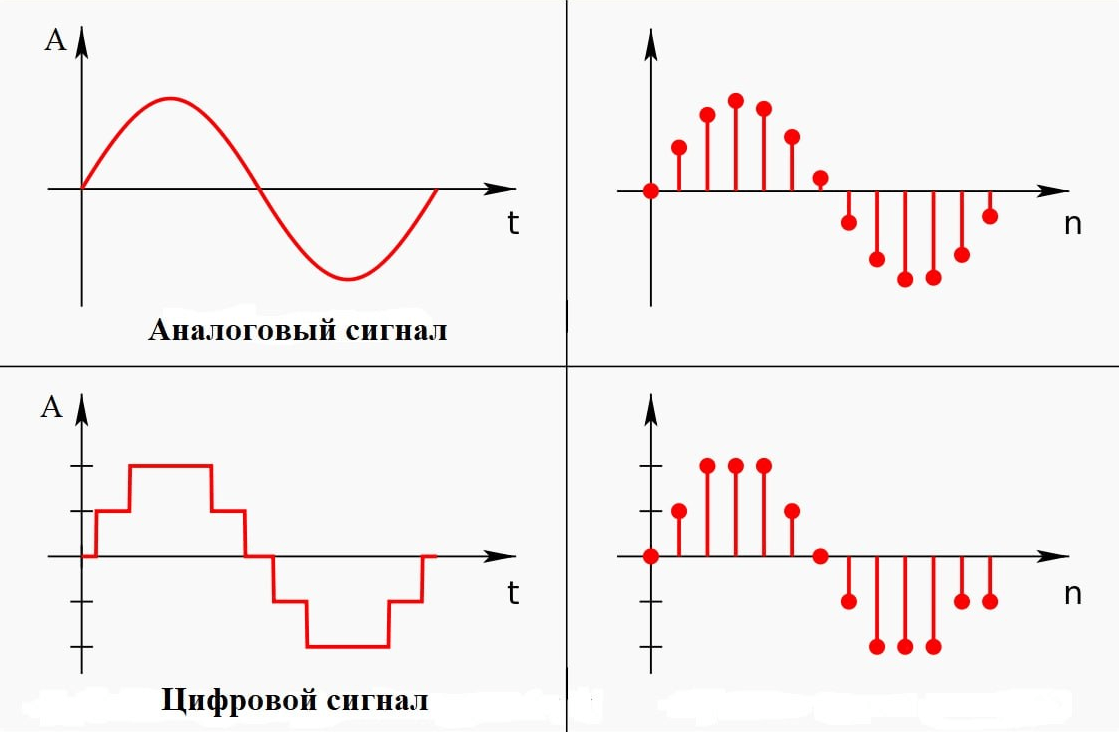

В жизни мы постоянно слышим или видим какие-нибудь сигналы. Сигнал — способ передачи информации. Для того чтобы информация в виде сигналов различного рода могла быть представленной в компьютере её кодируют определённым образом, т.е. превращают в последовательность электрических сигналов. У каждого цвета пикселя или текстового символа есть свой уникальный код, это позволяет преобразовывать информацию из одной формы в другую(кодировать и декодировать). Формы представления информации: Аналоговый(непрерывный) сигнал — информационный сигнал, который может меняться в любой момент времени. Например: Речь человека, пение птиц и т.п. Дискретный(цифровой) сигнал — информационный сигнал, который может меняться в определённый времени и принимать заранее определённые значения. Например: сигналы светофора, текст в книге и т.п. Непрерывные информационные сигналы могут принимать любые значения из всех возможных в рамках заданного интервала. В аналоговой форме сигнал описывается непрерывной функцией времени. В дискретной форме представления информации величины могут принимать лишь отдельные, неделимые значения и не могут принимать значения, промежуточные между ними. Все значения дискретного сигнала можно пронумеровать целыми числами. В дискретной форме сигнал представляется совокупностью символов из некоторого набора, называемого алфавитом. Если каждому символу присвоить числовое значение, то сигнал будет иметь цифровую форму отображения информации. В цифровой технике используется два символа: 0 и 1. Увеличивая количество разрядов, можно повысить точность представления информационного объекта. Аналоговый сигнал можно преобразовать в дискретный, и наоборот, для этого используются аналого-цифровые преобразователи(АЦП). Дискретизация — процесс превращения непрерывного сигнала в цифровой путём измерения числовых значений амплитуды сигнала через равные интервалы времени. Шаг дискретизации — промежуток времени, через который производятся замеры между сигналами.

Искажение информации

При передаче информации очень часто возникают помехи, и тогда информация от источника к приёмнику поступает в искажённом виде. В процессе передачи информация может теряться, искажаться: искажения звука в телефоне, атмосферные помехи по радио, искажение изображения при потоковой передачи и т.п. Эти помехи(шумы) создают проблемы для информации между источником и приёмником. Существует наука, разрабатывающая способы защиты информации – криптология. Ошибки, возникающие при передаче информации:

- часть правильной информации заменяется на неправильную;

- к передаваемой информации добавляются лишние, посторонние сообщения;

- часть информации при передаче пропадает;

Понятие шум применяется ко всему, что маскирует полезный сигнал, поэтому шумом может оказаться какой-нибудь другой сигнал(в таком случае он называется помехой), но обычно данный термин обозначает случайный шум физической(чаще всего тепловой) природы. Шум характеризуется своим частотным спектром, распределением амплитуды и источником, т.е. происхождением.

Скорость передачи информации

Обмен информацией или её передача производится по каналам связи. Канал связи — технические средства, позволяющие осуществлять передачу данных на расстоянии. Например, каналами связи являются органы чувств человека, техническими информационными каналами являются телефон, компьютерные сети. Информация по каналам связи передаётся с определённой скоростью. Скорость передачи информации — количество информации, передаваемое в единицу времени. При увеличении скорости передачи информации V в определённое количество раз время передачи t уменьшится в такое же количество раз(при неизменном размере файла). И наоборот, при уменьшении скорости передачи информации в определённое количество раз время передачи увеличится в такое же количество раз(при неизменном размере файла). При увеличении скорости передачи информации V в определённое количество раз количество передаваемой информации I может быть увеличено в такое же количество раз(при неизменном времени передачи). И наоборот, при уменьшении скорости передачи информации V в определённое количество раз количество информации I, которое может быть передано, уменьшится в такое же количество раз(при неизменном времени). Скорость измеряется в битах в секунду(бит/с) и кратных им величинах - Кбит/с, Мбит/с, а также в байтах в секунду (Б/с) и кратных им величинах - Кбайт/с, Гбайт/с. Пропускная способность канала — максимальное количество информации, которое может быть получено по этому каналу в единицу времени. Пропускная способность канала измеряется в тех же единицах, что и скорость передачи информации. Скорость передачи информации в конкретной паре "источник-приёмник" может быть разная, но пропускная способность канала остаётся неизменной.